人工知能の差別問題

意図せず人工知能に差別意識を学習させてしまうことが問題となっています.

原因は,人工知能(正確には機械学習アルゴリズム)に問題があるのではなく,学習に与えるデータの偏りが原因で問題が発生しているのです.

記事のアマゾンの技術職の採用判断の例では,過去10年間の採用実績をデータのほとんどが男性であったため,女性よりも男性を採用する傾向を学習してしまっています.

今の深層学習を含め機械学習は,基本的には入力変数 に対する判断

の集合が与えられたとき,

と

に対応するそれぞれ対応する確率変数

,

に関して予測する(確率)モデル

を構築することにより,新しい入力

に対して

が最大になる

を予測します.SVMなど学習アルゴリズムによっては,予測モデルが確率モデルではない場合もありますが,ここでは確率モデルとしておきます.

学習アルゴリズムは,入力変数のうちのどの変数がどの程度出力の判断に影響する因子となっているかを学習するため,採用される人がほとんど男というデータを与えると,自然と男であることを採用の因子として強めることになります.

UC BerkeleyのMoritz Hardt助教は,男女など特定の条件に関する公平さを Demographic Parity (人口動態学的一致性)と定義しています.

blog.mrtz.org

まず,公平性を確保したい因子に対する変数を指定し,Protected Variable(保護された変数)と呼ぶことにします.

Demographic Parity (DP) はあるProtected Variable Xに関して,下記で定義される.

for all the values

for

つまり,Xがどのような値をとっても結果に依存しないことを指しています.

が男maleが女femaleかを表す変数であるとすると,

とならなれけばならないということです.

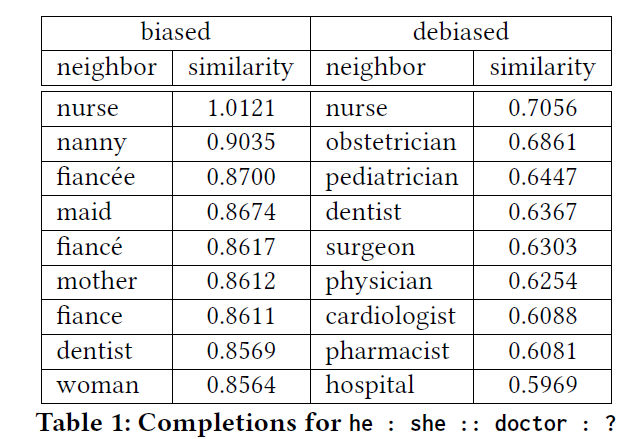

それならば最初からProtected Varialbe を学習に入れなければいいように思いますが,そうはいかない場合もあります.たとえば,単語の意味を数値ベクトルで表現するword2vecのような,単語の表現学習においてもバイアスが生じます. 2018 AAAI/ACM Conference on AI, Ethics, and Society で発表されたMitigating Unwanted Biases with Adversarial Learningの中では,Zhangらが下の表のような例を挙げています.he:she=doctor:? これは,heがsheに対応するとするとdoctorは何に対応するかという類推を表現したもので,単語の埋め込み表現の評価法としてよく用いられます.たとえば,UK:London=Japan:?のようにイギリスのロンドンに相当する日本のもの?を予測する表現として使われます.

女性の職業に近いものを左のように選んでしまう傾向があります.これを敵対的学習によりバイアスを右のように修正するというのがこの論文の面白いところです.